Izmēģiniet MI savā tīmekļa vietnē 60 sekundēs

Skatiet, kā mūsu MI acumirklī analizē jūsu tīmekļa vietni un izveido personalizētu tērzēšanas robotu - bez reģistrācijas. Vienkārši ievadiet savu URL un vērojiet, kā tas darbojas!

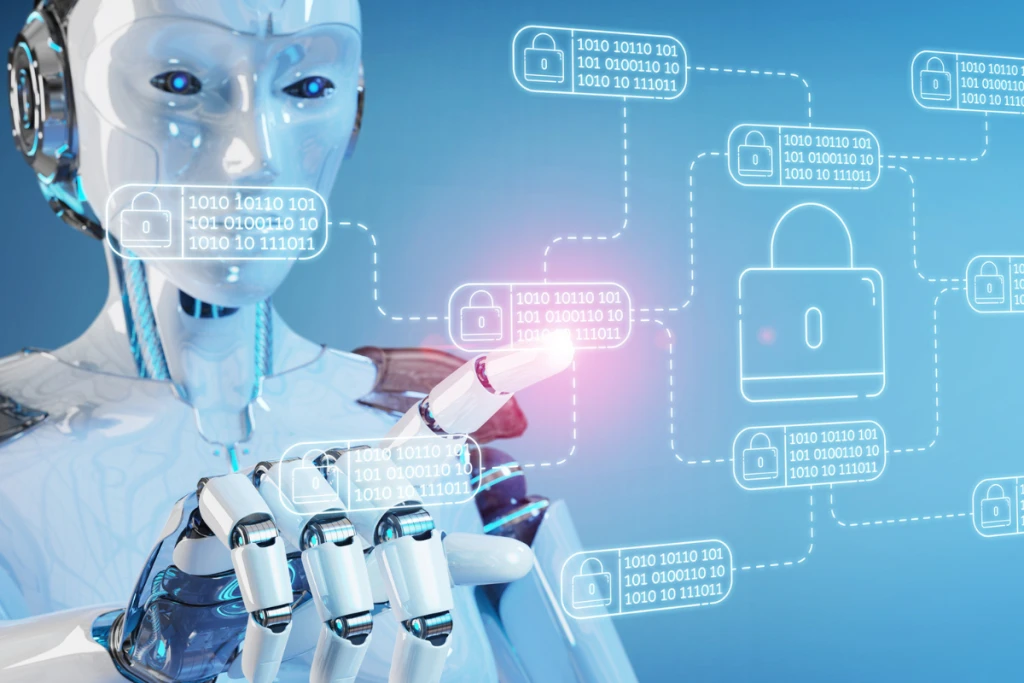

Ievads AI un datu konfidencialitātē

Datu privātums attiecas uz personas informācijas aizsardzību pret nesankcionētu piekļuvi, ļaunprātīgu izmantošanu vai iedarbību. AI sistēmām bieži vien ir nepieciešamas plašas datu kopas, lai tās efektīvi darbotos, radot tādus potenciālus riskus kā datu pārkāpumi, identitātes zādzība un algoritmu aizspriedumi. Tā kā AI turpina attīstīties, ir svarīgi līdzsvarot inovācijas ar ētiskiem un juridiskiem apsvērumiem, lai nodrošinātu lietotāju datu drošību.

Privātuma izaicinājumi AI laikmetā

Masveida datu vākšana

Daudzām mākslīgā intelekta lietojumprogrammām, piemēram, ieteikumu sistēmām, sejas atpazīšanas tehnoloģijai un balss palīgiem, ir nepieciešams liels datu apjoms, lai uzlabotu to precizitāti un veiktspēju. Tas noved pie nepārtrauktas datu vākšanas no lietotājiem, bieži vien bez viņu skaidras ziņas vai piekrišanas. Sociālo mediju platformas, piemēram, izseko lietotāju mijiedarbību, lai uzlabotu viņu algoritmus, taču šī prakse var izjaukt robežu starp personalizētu pieredzi un invazīvu uzraudzību.

Pārredzamības trūkums

Viena no lielākajām AI problēmām ir tās "melnās kastes" raksturs. Daudzi ar AI balstīti lēmumi nav viegli izskaidrojami, tāpēc lietotājiem ir grūti saprast, kā tiek izmantoti viņu dati. Ja mākslīgā intelekta modelis liedz personai aizdevumu vai darba iespēju, pamatojoties uz tā analīzi, ietekmētajai personai var nebūt iespējas saprast vai apstrīdēt lēmumu. Šis pārredzamības trūkums var mazināt uzticību AI sistēmām un radīt ētiskas bažas.

Neobjektivitāte un diskriminācija

AI sistēmas tiek apmācītas, izmantojot vēsturiskos datus, kuros var būt raksturīgas novirzes. Ja AI modeļi netiek rūpīgi pārvaldīti, tie var iemūžināt vai pat pastiprināt diskrimināciju. Piemēram, ir konstatēts, ka neobjektīvas sejas atpazīšanas sistēmas biežāk nepareizi identificē personas no noteiktām demogrāfiskām grupām. Tas rada ne tikai ētiskas bažas, bet arī juridiskus riskus uzņēmumiem, kas paļaujas uz AI balstītu lēmumu pieņemšanu.

Uzlabota uzraudzība

Ar AI vadīti novērošanas rīki, piemēram, sejas atpazīšana un uzvedības izsekošana, kļūst arvien izplatītāki. Lai gan šīs tehnoloģijas var uzlabot drošību, tās arī nopietni apdraud privātumu. Valdības un korporācijas var izmantot mākslīgo intelektu, lai uzraudzītu personas bez viņu piekrišanas, radot bažas par masveida uzraudzību un iespējamu personas datu ļaunprātīgu izmantošanu.

Personas datu aizsardzības paraugprakse AI lietojumprogrammās

Datu minimizēšana

Organizācijām ir jāapkopo tikai tie dati, kas nepieciešami to AI lietojumprogrammām. Uzglabājamās personas informācijas apjoma samazināšana samazina datu iedarbības risku pārkāpuma gadījumā.

Datu maskēšana un pseidonimizācija

Tādas metodes kā datu maskēšana (sensitīvu datu aizstāšana ar fiktīvām vērtībām) un pseidonimizācija (tiešo identifikatoru noņemšana no datu kopām) var uzlabot privātumu, vienlaikus ļaujot AI modeļiem darboties efektīvi.

Informēta piekrišana un lietotāju informētība

Lietotājiem jābūt skaidrai un pieejamai informācijai par to, kā tiek vākti, izmantoti un uzglabāti viņu dati. Ieviešot izvēles politikas, nevis automātisku datu apkopošanu, tiek nodrošināta lielāka pārskatāmība un lietotāju kontrole.

Regulāras drošības pārbaudes

AI sistēmām ir jāveic biežas drošības pārbaudes, lai noteiktu ievainojamības un iespējamos privātuma riskus. Tas ietver datu noplūdes, nesankcionētas piekļuves un novirzes noteikšanas testēšanu.

Spēcīgi šifrēšanas protokoli

Saglabāto un pārsūtīto datu šifrēšana pievieno papildu drošības līmeni, apgrūtinot nesankcionētu personu piekļuvi sensitīvai informācijai.

Normatīvie regulējumi un atbilstība

Vispārīgā datu aizsardzības regula (GDPR)

VDAR, ko īsteno Eiropas Savienība, nosaka stingras vadlīnijas par datu vākšanu, glabāšanu un lietotāju piekrišanu. Uzņēmumiem ir jānodrošina datu izmantošanas pārredzamība un jāļauj personām pieprasīt datu dzēšanu.

Kalifornijas Patērētāju privātuma likums (CCPA)

Šis ASV regulējums nodrošina Kalifornijas iedzīvotājiem lielāku kontroli pār saviem personas datiem, pieprasot uzņēmumiem atklāt datu vākšanas praksi un nodrošināt atteikšanās iespējas.

AI specifiskas ētikas vadlīnijas

Vairākas organizācijas, tostarp ESAO un UNESCO, ir ieviesušas ētiskas mākslīgā intelekta vadlīnijas, uzsverot pārredzamību, godīgumu un atbildību AI izstrādē un ieviešanā.

Organizāciju loma datu privātuma nodrošināšanā

Ētisku AI ietvaru izstrāde: AI izstrādes iekšējo vadlīniju noteikšana, kurās prioritāte ir lietotāja privātumam un ētiskiem apsvērumiem.

Darbinieku apmācība par datu aizsardzību: darbinieku izglītošana par datu drošības paraugpraksi un atbilstību privātuma noteikumiem.

Integrētās privātuma ieviešana: datu aizsardzības pasākumu integrēšana mākslīgā intelekta projektu izstrādes stadijā, nevis pēc tam.

Iesaistīšanās caurspīdīgā saziņā: skaidru skaidrojumu sniegšana lietotājiem par to, kā tiek izmantoti viņu dati, un nodrošināt, ka viņi var kontrolēt savu informāciju.

Nākotnes perspektīva: inovāciju un privātuma līdzsvarošana

Federatīvā mācīšanās: decentralizēta pieeja AI apmācībai, kas ļauj modeļiem mācīties no datiem, nepārsūtot tos uz centrālo serveri, tādējādi uzlabojot privātumu.

AI regulējums un ētiskā AI attīstība: tiek sagaidīts, ka valdības visā pasaulē ieviesīs stingrākus AI noteikumus, lai novērstu ļaunprātīgu izmantošanu un nodrošinātu datu aizsardzību.

Lielāka lietotāju kontrole pār datiem: jaunās tehnoloģijas var piedāvāt personām lielāku kontroli pār saviem personas datiem, piemēram, pašsuverēnās identitātes sistēmas, kas izmanto blokķēdi.